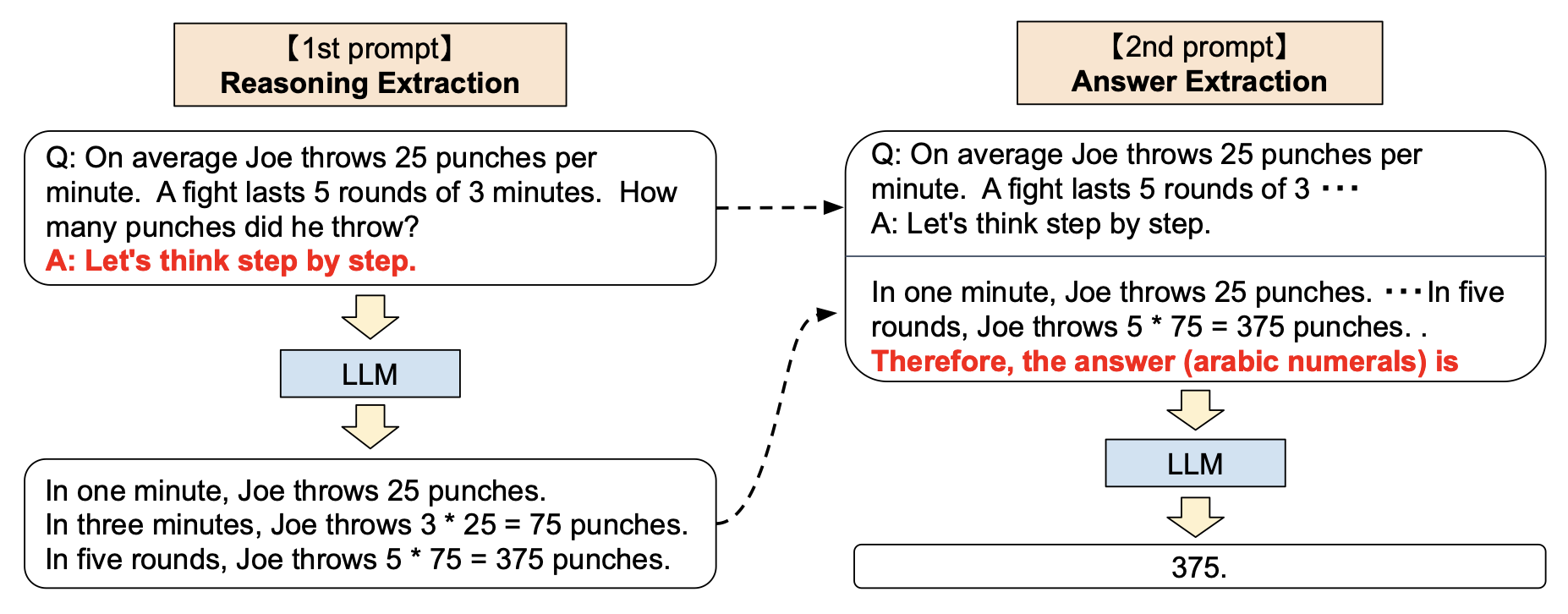

纽约大学最近的研究成果对目前广泛应用的思维链技术(Chain-of-Thought,简称 CoT)提出了新的质疑。思维链技术原被认为是增强大型模型推理能力的关键,但该研究发现,简单使用省略号(…)替代具体的推理步骤,并不会对推理结果造成明显影响,这表明模型性能的提升可能更多地依赖于计算资源的增加。

研究团队采用了包括3SUM和2SUM-Transform在内的测试任务来评估这一假设。在3SUM任务中,模型需要从一系列数字中选出三个数使其和满足特定条件。通过对比使用省略号填充token的方法与传统的CoT方法,结果显示两者在精度上相差无几。这种现象在2SUM-Transform任务中同样得到了验证,该任务通过对数字进行随机偏移,防止模型简单地计算出答案。

这一发现不仅挑战了传统对模型推理过程的理解,而且引起了关于模型可能在不显性推理过程中执行任务的讨论,这种情况可能使模型的操作部分脱离人类的直接控制。虽然使用省略号作为填充token在实验中证明了有效性,但这种方法并未改变Transformer模型在计算复杂度上的固有限制,并需要针对性的训练过程。

这项研究不仅为理解大型语言模型的工作机制提供了新的视角,同时也对AI的安全性和未来的发展方向提出了进一步的思考。