腾讯今日宣布推出业界参数规模最大的开源MoE(Mixture of Experts)大语言模型——Hunyuan-Large。这一模型以总参数量398B、激活参数52B及训练token数达7万亿,成为业内最先进的大语言模型之一,最大上下文长度达到256K,显著提高了处理长文本的能力。

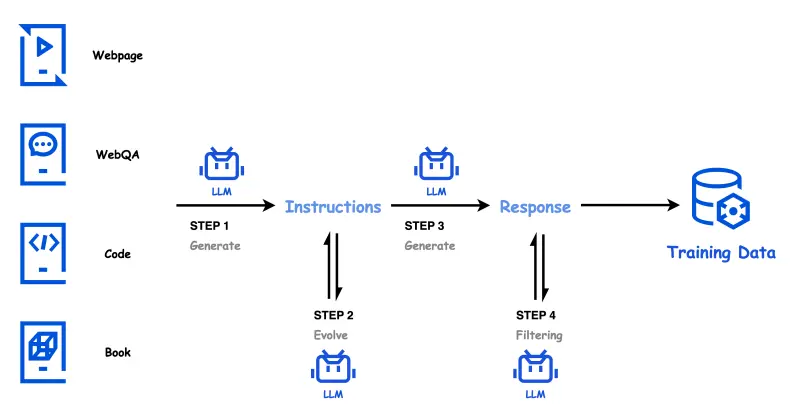

Hunyuan-Large模型通过高质量的合成数据进行训练,有效弥补了自然数据不足的问题。在技术性能上,该模型在多项综合评测中展现了卓越的表现,包括CMMLU、MMLU、CEva1和MATH等领域,全面领先于Llama3.1和Mixtral等顶级开源模型。Hunyuan-Large在中英文自然语言处理、代码生成、数学运算等9大能力维度中均取得了优异成绩。

为推动长文本任务研究,腾讯还宣布推出自研的长文评测集“企鹅卷轴(PenguinScrolls)”,专门用于长文本处理能力的评估。企鹅卷轴涵盖从1K到128K长度的文本,基于金融、法律、学术论文等内容,支持深度阅读理解和长文推理任务,填补了行业在真实长文评测集上的空白。

这一新模型及其评测工具的发布,将进一步推动自然语言处理技术的发展,并助力研究者更高效地进行大语言模型的创新与应用。